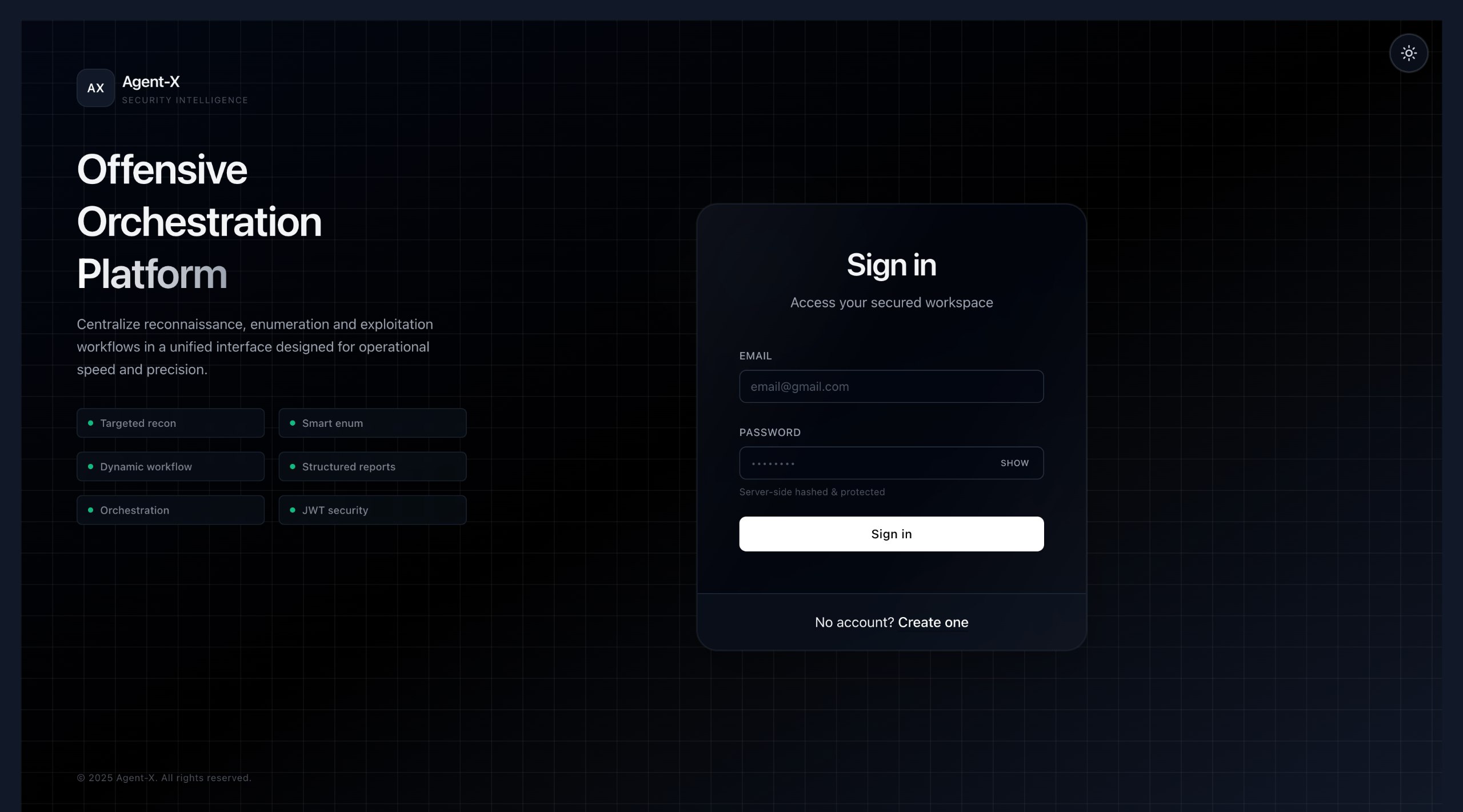

Agent‑X — Outil d’automatisation de pentesting

Automatisation de tests de pénétration avec un agent intelligent.

0% chargé

Étudiant ingénieur en Data Science & IA, spécialisé en Data Engineering et Big Data, avec des compétences en Développement Backend et Deep Learning. Réalisation de projets pratiques et scalables pour résoudre des problématiques concrètes.

Étudiant en dernière année de cycle ingénieur en Data Science & IA, spécialisé en Big Data et Data Engineering. Passionné par les architectures distribuées, le backend, l'administration Linux et le DevOps pour pipelines data.

Mon objectif : concevoir et opérer des plateformes data scalables et fiables, de l'ingestion au serving, avec qualité, sécurité et performance.

Status

Langages, Big Data, Cloud, Bases de données, Outils

Sélection de travaux techniques et académiques

Automatisation de tests de pénétration avec un agent intelligent.

Traitement d'événements, windowing et agrégations en temps réel.

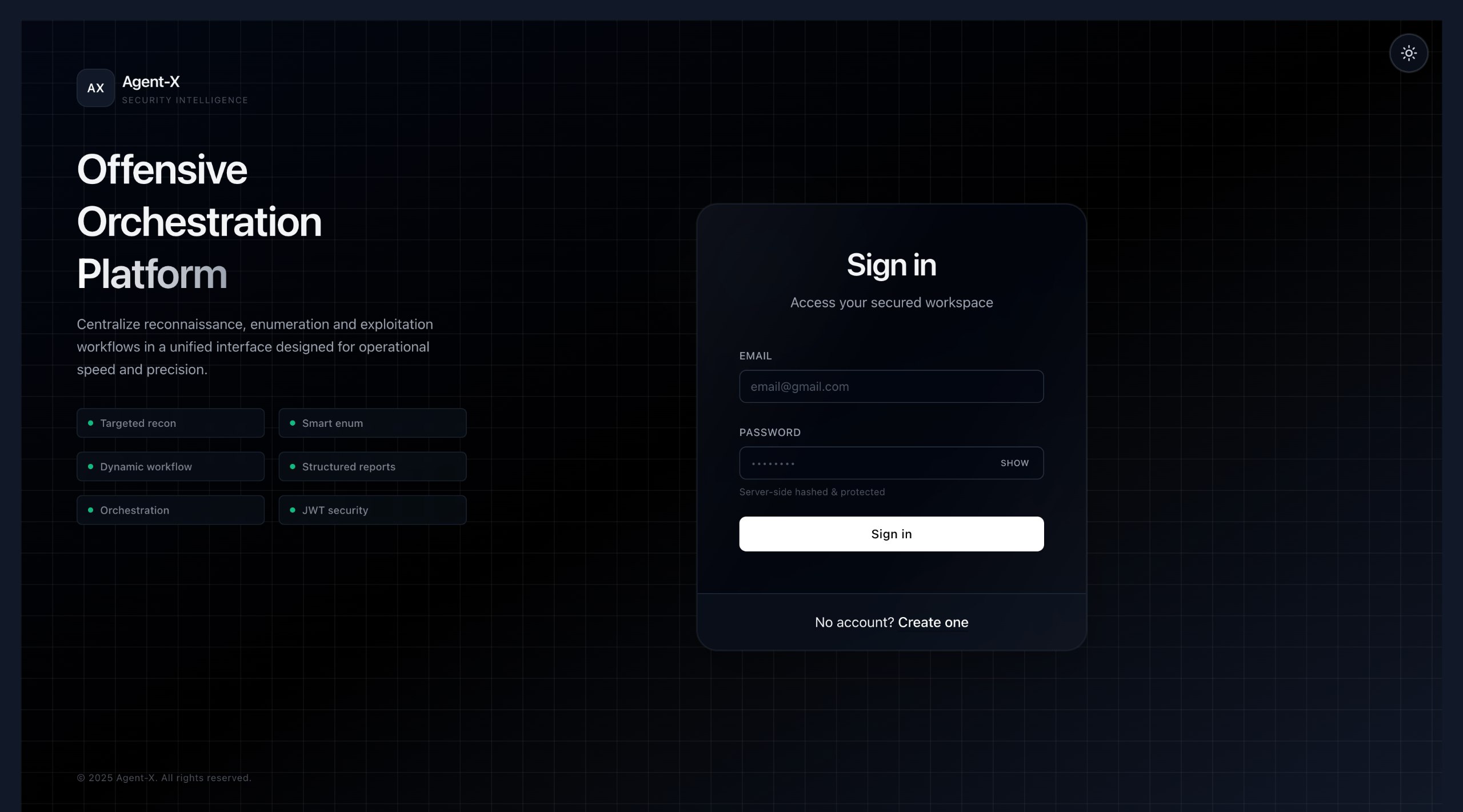

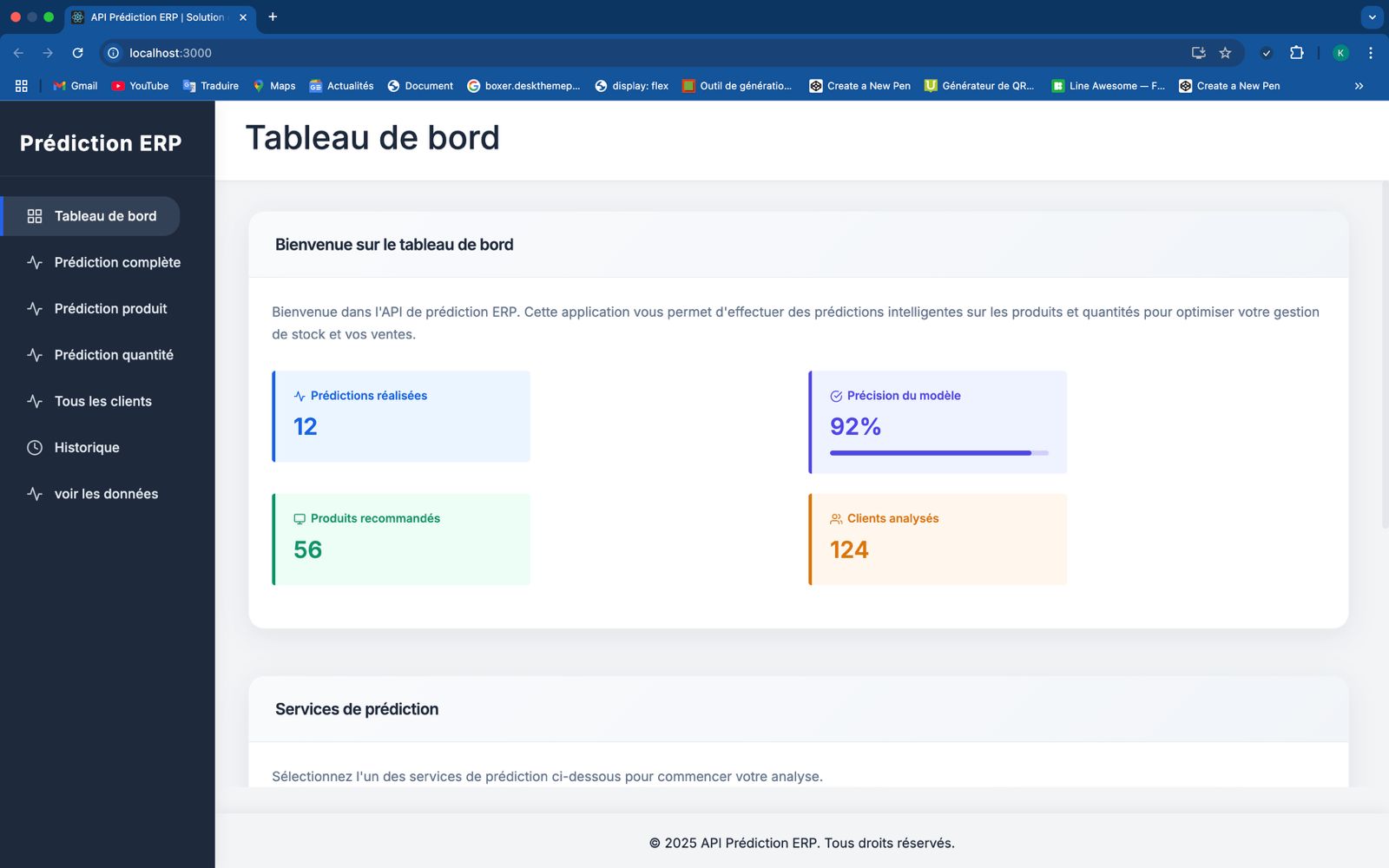

Pipeline local de data engineering pour données hospitalières (Diabetes 130) avec ingestion, transformation et orchestration via Airflow, MinIO, PostgreSQL et Python.

Missions et réalisations professionnelles

Titres et validations de compétences

Connaissances en Intelligence Artificielle et Data Engineering acquises à travers des projets académiques et personnels.

Développement de modèles avec TensorFlow et Keras. Réalisation de projets en Vision par Ordinateur et Traitement du Langage Naturel (NLP) dans le cadre académique.

Conception de pipelines ETL et traitement de données volumineuses avec Airflow, Apache Spark et Kafka pour des projets universitaires et personnels.

Création d'API et services backend pour projets scolaires et personnels. Expérience en gestion de bases de données et optimisation de performances.

Discutons de vos besoins data

Discutons de vos projets et de comment je peux vous aider.

Disponible pour freelance & CDI